- 科研进展

-

王美丽教授课题组在虚拟现实姿态识别领域取得新进展

作者: 来源: 发布日期:2021-11-03 浏览次数:论文题目: Classifying In-Place Gestures with End-to-End Point Cloud Learning

作者: Lizhi Zhao, Xuequan Lu, Min Zhao, Meili Wang (通讯作者)

会议名称: IEEE International Symposium on Mixed and Augmented Reality (中国计算机学会B类会议)

发表时间: 2021年10月

简介:

近日,信息工程学院王美丽教授课题组在虚拟现实领域顶级会议ISMAR发表研究论文:“Classifying In-Place Gestures with End-to-End Point Cloud Learning”。我校硕士生赵励志为第一作者,迪肯大学鲁学权助理教授为共同一作,我校本科生赵敏为第三作者,王美丽教授为论文通讯作者。该研究得到陕西省林业科学院2021年科技创新计划专项(SXLK2021-0214)的资助。

论文摘要:

虚拟现实技术的一个重要应用是在大型虚拟场景中漫游。原地行走方法是用户通过原地踏步或原地跑动等方式代替真实走动,在物理空间中保持位置不变或仅仅在小范围移动,从而实现在超出物理空间大小的大型虚拟场景中漫游的效果。原地行走方法提供了与真实行走相似的感官反馈,相比基于控制器漫游的方法,原地行走方法使得用户具有更高的空间感知体验,具有较高的沉浸感和自然感,并且减缓了晕动症。近些年的原地行走方法通常利用CNN或LSTM等神经网络识别某些姿态(如站立、行走等),然而这些方法往往只考虑了少量姿态类别并且具有较高的延迟。

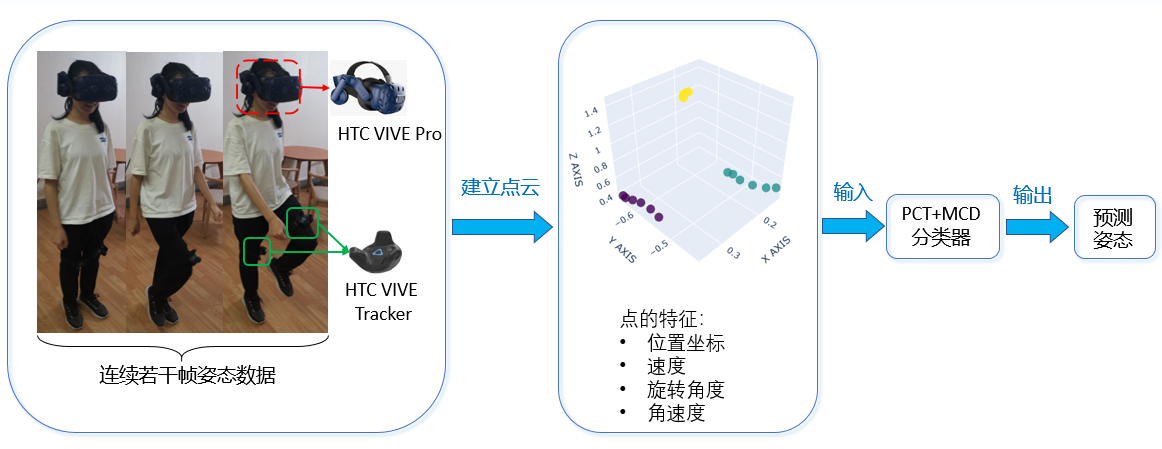

此次发表的研究论文的目的是建立一个能够快速、准确地识别用户的原地姿态的模型,用于虚拟漫游交互。为此,论文首先使用HTC VIVE Pro HMD和两个VIVE追踪器采集用户的原地姿态数据,其中每个设备在每一帧提供一个点,每个点的特征包括用户的头部或大腿部位的三维位置坐标、线性速度、旋转角度和角速度。论文将连续若干帧的数据分割为一个点云样本,并手工标记所有的样本,建立一个点云数据集。考虑到用户之间的人体差异,论文设计了一个基于点云的分类网络,将无监督领域迁移学习和有监督点云学习结合起来,联合进行有监督和无监督的训练。论文的方法总体概述见下图,HMD和2个追踪器采集的连续若干帧姿态数据被转换为一个点云样本,并被输入PCT+MCD分类器,用于实时识别用户的原地运动姿态。

实验结果表明,论文方法在9种原地姿态类别的分类任务上取得了95.0%的总体准确率和实时的交互性能(192ms延迟)。

论文链接: https://ieeexplore.ieee.org/document/9583828